Le retour d'expérience du mois

Une IA Générative éco-responsable et sécurisée chez VeoliaFouad Maach - Group Head of Architecture & Industrialization chez Veolia

Retour

Fouad Maach est Group Head of Architecture & Industrialization chez Veolia. Lors de la matinale Numérique Responsable, il a partagé le retour d’expérience sur la plateforme Veolia Secure GPT, déployée on-premises dans un souci de confidentialité et de réduction de l’empreinte carbone.

Bien avant l’arrivée de la GenAI, nous avions déjà des convictions fortes sur la façon de construire et d’utiliser nos infrastructures. Dès 2018, nous avons donné un coup d’accélérateur à notre stratégie Move To Public Cloud. L’une des raisons, en plus de la sécurité et de la haute disponibilité apportées par les solutions de Cloud public, est une consommation énergétique optimisée grâce à l’expertise des grands acteurs du marché.

De plus, avec les hyperscalers que nous avons choisis, nous pouvons orienter le déploiement de nos applications vers les régions ayant un impact carbone le plus faible.

Nous essayons aussi de nous prémunir contre l’avalanche de requêtes quasi-identiques de la part des utilisateurs. Par exemple, notre service de génération d’image est uniquement accessible par les équipes marketing ou commerciales, qui représentent moins de 10% de l’effectif Veolia. Ces images générées sont analysées par le Marketing Communication, qui sélectionne les meilleures pour les mettre à disposition de tous les collaborateurs dans notre bibliothèque d’images.

Enfin, notre approche serverless par défaut, fait que nous ne provisionnons des ressources que lorsque nous en avons besoin, ce qui évite une consommation énergétique inutile avec des infrastructures traditionnelles.

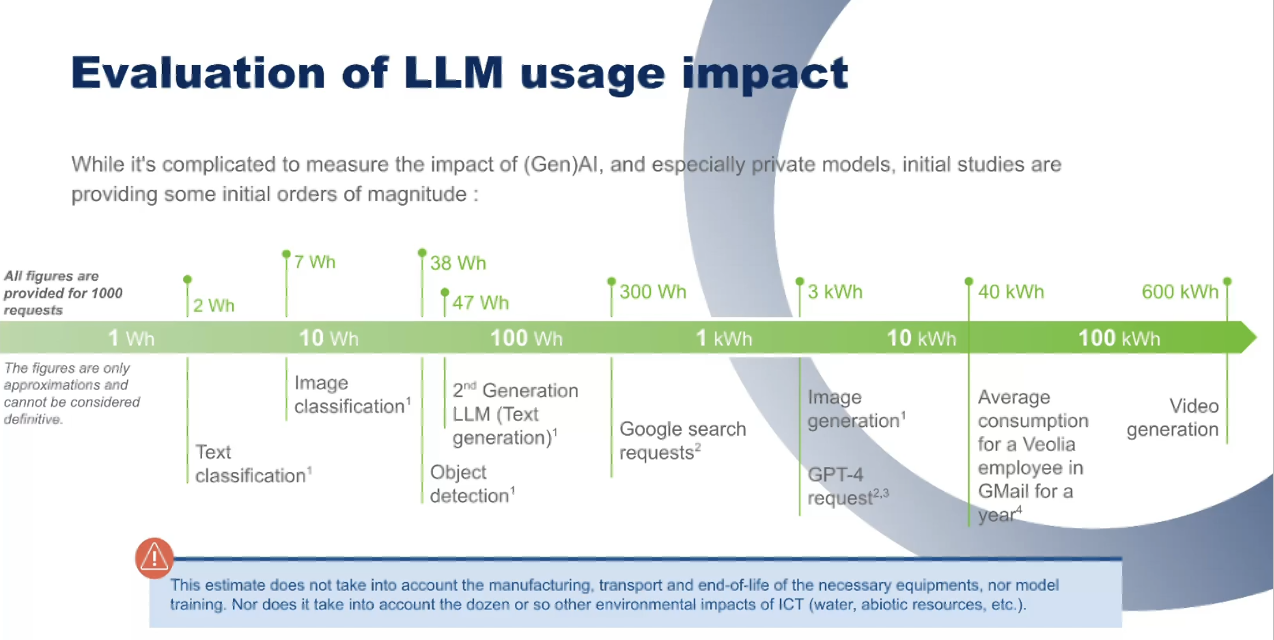

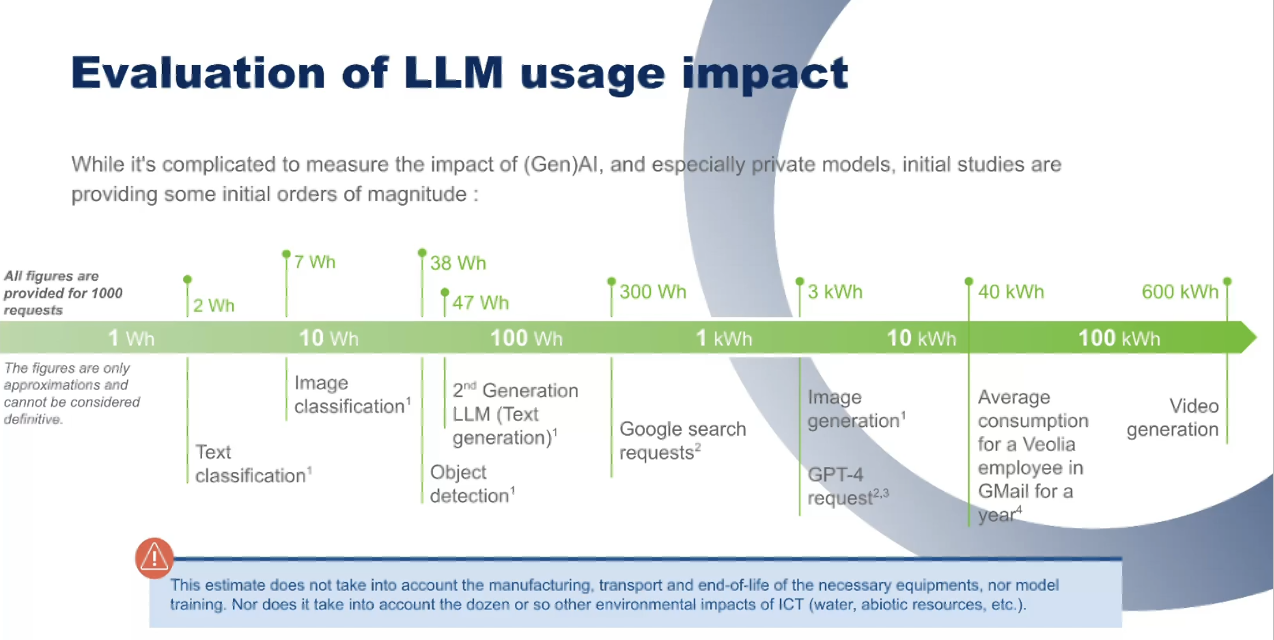

La plus faible consommation est liée à l’utilisation d’outils AI de classification de texte (2 Wh). Et la plus forte est atteinte avec la génération d’images vidéo à partir de la GenAI (de l’ordre de 600 kWh)

Nous avons également calculé ce que consomment 1.000 requêtes utilisateur, ce qui correspond en moyenne aux nombres de prompts annuel d’un utilisateur actif de notre plateforme. Nous avons compilé avec l’aide de différents outils la consommation énergétique de la messagerie, de modèles énergivores comme la première génération de GPT4, et de modèles LLM optimisés de petite taille qui permettent une réduction significative de la consommation énergétique.

Nous nous appuyons sur des modèles AI mis à disposition en mode serveless, proposées par les 3 grands hyperscalers, en sélectionnant les régions optimales. Nous analysons la consommation énergétique avec les outils proposés par les 3 hyperscalers, que l’on complète avec 3 outils tiers qui sont Code Carbon, Boavizta et EcoLogits, qui nous permettent d’affiner notre analyse énergétique au niveau du code et des modèles de GenAI.

En 2024, notre objectif était d’accélérer l’adoption et la formation des collaborateurs pour qu’ils prennent l’outil en main, et qu’ils découvrent comment utiliser notre plateforme, voir les limites de l’IA ou l’IA Gen, en évaluant les éléments positifs comme les risques à éviter.

Maintenant que l’usage s’est généralisé, en 2025 nous passons à une 2ème étape de l’utilisation de la GenAI. Nous voulons obtenir un usage plus mesuré de la GenAI et un meilleur ROI. Nous nous assurons que la GenAI fait gagner du temps à nos collaborateurs, mais aussi que la consommation des outils a un impact environnemental globalement positif.

Pour ce faire, à la fin de l’année 2024, nous développons un dispositif qui permettra prochainement aux utilisateurs de suivre leur consommation énergétique mensuelle, et profiter d’un routage dynamique entre les différents LLMs disponibles. Aujourd’hui l’utilisateur doit choisir parmi les 15 LLM disponibles via Veolia Secure GPT, avec des recommandations fournies par l’application.

Pour simplifier le choix de l’utilisateur, nous mettons au point un dispositif de routage dynamique, qui, en fonction de la question posée, aiguillera l’utilisateur vers le LLM le plus à même de répondre à sa question, tout en optimisant la réduction de l’impact énergétique.

Nous travaillons également sur la mise en place d’indicateurs qui seront affichés pendant l’utilisation, et des indicateurs envoyés chaque mois aux utilisateurs, ce qui permettra aux utilisateur de disposer de données factuelles sur la consommation énergétique qu’il engendre, et de mesurer aussi celle des applications.

De plus, les cas d’usage que l’on traite n’ont pas besoin d’entrainer une consommation énergétique inutile en se lançant dans l’entrainement ou le fine-tuning de modèles.

L’avantage de ces petites modèles est qu’ils sont ouverts et déployables localement, ce qui nous permet de répondre aux problèmes de connectivité que nous rencontrons sur certains sltes.

L’AI et la GenAI sont à la fois des risques de dégradation de l’empreinte environnementale et des solutions qui vont améliorer notre catalogue de services de décarbonation, que ce soit sur les métiers de l’eau, des déchets ou de l’énergie.

Pourquoi définir une stratégie GenAI On-Premises ?

En Juin 2023 nous avons pris la décision de lancer notre plateforme Veolia Secure GPT déployée en interne pour 3 raisons majeures :- Combattre le shadow IA qui commençait à apparaître dans certaines de nos entités,

- Eviter le risque de perte de notre propriété intellectuelle en utilisant des solutions du marché qui peuvent se servir de nos données afin d’améliorer leurs propres modèles,

- Etre assurés que Veolia détienne la propriété complète des réponses fournies par l’IA, ce qui n’est pas toujours certains avec certaines IA publiques.

Comment concilier GenAI et objectifs de réduction de l’empreinte énergétique ?

L’activité de Veolia nous engage à respecter l’environnement, et donc à limiter notre consommation énergétique, notamment celle de notre SI.Bien avant l’arrivée de la GenAI, nous avions déjà des convictions fortes sur la façon de construire et d’utiliser nos infrastructures. Dès 2018, nous avons donné un coup d’accélérateur à notre stratégie Move To Public Cloud. L’une des raisons, en plus de la sécurité et de la haute disponibilité apportées par les solutions de Cloud public, est une consommation énergétique optimisée grâce à l’expertise des grands acteurs du marché.

De plus, avec les hyperscalers que nous avons choisis, nous pouvons orienter le déploiement de nos applications vers les régions ayant un impact carbone le plus faible.

Nous essayons aussi de nous prémunir contre l’avalanche de requêtes quasi-identiques de la part des utilisateurs. Par exemple, notre service de génération d’image est uniquement accessible par les équipes marketing ou commerciales, qui représentent moins de 10% de l’effectif Veolia. Ces images générées sont analysées par le Marketing Communication, qui sélectionne les meilleures pour les mettre à disposition de tous les collaborateurs dans notre bibliothèque d’images.

Enfin, notre approche serverless par défaut, fait que nous ne provisionnons des ressources que lorsque nous en avons besoin, ce qui évite une consommation énergétique inutile avec des infrastructures traditionnelles.

Comment évaluez-vous l’impact énergétique de la GenAI ?

Nous avons travaillé sur la mise à jour de l’évaluation de la consommation des outils d’AI et de GenAI utilisés chez VEOLIA pour positionner la consommation de ces différents outils.La plus faible consommation est liée à l’utilisation d’outils AI de classification de texte (2 Wh). Et la plus forte est atteinte avec la génération d’images vidéo à partir de la GenAI (de l’ordre de 600 kWh)

Nous avons également calculé ce que consomment 1.000 requêtes utilisateur, ce qui correspond en moyenne aux nombres de prompts annuel d’un utilisateur actif de notre plateforme. Nous avons compilé avec l’aide de différents outils la consommation énergétique de la messagerie, de modèles énergivores comme la première génération de GPT4, et de modèles LLM optimisés de petite taille qui permettent une réduction significative de la consommation énergétique.

Nous nous appuyons sur des modèles AI mis à disposition en mode serveless, proposées par les 3 grands hyperscalers, en sélectionnant les régions optimales. Nous analysons la consommation énergétique avec les outils proposés par les 3 hyperscalers, que l’on complète avec 3 outils tiers qui sont Code Carbon, Boavizta et EcoLogits, qui nous permettent d’affiner notre analyse énergétique au niveau du code et des modèles de GenAI.

Où en êtes-vous dans le déploiement de Veolia Secure GPT ?

Notre plateforme a été ouverte en Septembre 2023, et elle compte aujourd’hui 65.000 utilisateurs actifs par mois. Cette plateforme est agnostique et permet d’accéder à une quinzaine de LLM.En 2024, notre objectif était d’accélérer l’adoption et la formation des collaborateurs pour qu’ils prennent l’outil en main, et qu’ils découvrent comment utiliser notre plateforme, voir les limites de l’IA ou l’IA Gen, en évaluant les éléments positifs comme les risques à éviter.

Maintenant que l’usage s’est généralisé, en 2025 nous passons à une 2ème étape de l’utilisation de la GenAI. Nous voulons obtenir un usage plus mesuré de la GenAI et un meilleur ROI. Nous nous assurons que la GenAI fait gagner du temps à nos collaborateurs, mais aussi que la consommation des outils a un impact environnemental globalement positif.

Pour ce faire, à la fin de l’année 2024, nous développons un dispositif qui permettra prochainement aux utilisateurs de suivre leur consommation énergétique mensuelle, et profiter d’un routage dynamique entre les différents LLMs disponibles. Aujourd’hui l’utilisateur doit choisir parmi les 15 LLM disponibles via Veolia Secure GPT, avec des recommandations fournies par l’application.

Pour simplifier le choix de l’utilisateur, nous mettons au point un dispositif de routage dynamique, qui, en fonction de la question posée, aiguillera l’utilisateur vers le LLM le plus à même de répondre à sa question, tout en optimisant la réduction de l’impact énergétique.

Nous travaillons également sur la mise en place d’indicateurs qui seront affichés pendant l’utilisation, et des indicateurs envoyés chaque mois aux utilisateurs, ce qui permettra aux utilisateur de disposer de données factuelles sur la consommation énergétique qu’il engendre, et de mesurer aussi celle des applications.

Comment entraînez-vous et optimisez-vous vos modèles ?

Jusqu’à aujourd’hui notre choix est de s’interdire d’entrainer ou de fine tuner nos propres modèles. La raison est simple : durant nos phases d’expérimentation, nous avons constaté qu’une approche RAG classique donne de meilleurs résultats, et qu’elle est beaucoup plus facile à maintenir qu’un modèle qui serait fine-tunés régulièrement pour être mis à jour par rapport aux sources d’information qu’il consulte.De plus, les cas d’usage que l’on traite n’ont pas besoin d’entrainer une consommation énergétique inutile en se lançant dans l’entrainement ou le fine-tuning de modèles.

Investiguez-vous l’utilisation de modèles plus réduits que les grands LLM du marché ?

Depuis juin 2024, nous travaillons sur des use case utilisant des données d’usine pour valider l’usage de petits modèles (SLM) et valider que ces modèles permettent de répondre aux besoins des usines, voire sur des sites commerciaux, sans avoir à déployer des modèles LLM très chersL’avantage de ces petites modèles est qu’ils sont ouverts et déployables localement, ce qui nous permet de répondre aux problèmes de connectivité que nous rencontrons sur certains sltes.

Au final, quelles leçons tirez-vous de cette expérience ?

L’objectif de notre approche, ce n’est surtout pas d’interdire l’utilisation de l’IA traditionnelle, ni de la GenAI. D’ailleurs, nous utilisons depuis quelques temps l’IA en production pour optimiser par exemple le déplacement de nos flottes de camions de ramassage, ou pour améliorer la qualité du tri dans les centres de déchet, et faire en sorte que moins de déchets partent en incinération et que davantage soient dirigés vers des filières de recyclage.L’AI et la GenAI sont à la fois des risques de dégradation de l’empreinte environnementale et des solutions qui vont améliorer notre catalogue de services de décarbonation, que ce soit sur les métiers de l’eau, des déchets ou de l’énergie.

Autres articles sur le même thème

Le retour d'expérience du mois

Déploiement d'une communauté Citizen Development à la Société Générale

Dorian Gougeon, Chapter Manager Citizen Dev et AI Officer - Société Générale Securities Services

Dorian Gougeon, Chapter Manager Citizen Dev et AI Officer - Société Générale Securities Services

Mag #26

Lire l'article