Quoi de neuf dans la Silicon Valley ?

Quand les géants du cloud conçoivent et commercialisent leurs propres puces IA L’intégration verticale redéfinit l’IA mondialepar Georges Nahon

Retour

Depuis près d’une décennie, une transformation profonde mais longtemps restée discrète bouleverse le cœur technologique de l’intelligence artificielle. Les hyperscalers, les grands acteurs du cloud (Google, Amazon, Microsoft et plus récemment Meta), ne sont plus seulement des acheteurs de circuits intégrés spécialisés, mais des concepteurs de puces à part entière, engagés dans une stratégie d’intégration verticale qui redéfinit l’équilibre industriel mondial de l’IA.

Pendant près de dix ans, ces développements restent largement invisibles, cantonnés à l’optimisation interne des coûts et des performances. L’IA générative agit comme un révélateur : elle transforme ces investissements de long terme en levier central de compétitivité. À partir de 2024–2025, certaines de ces puces cessent d’être de simples outils internes pour devenir visibles, revendiquées et, dans certains cas, commercialisées auprès de tiers.

Dans ce contexte, réduire le coût marginal par requête devient un avantage compétitif décisif. En concevant leurs propres accélérateurs, les hyperscalers peuvent optimiser très finement leurs architectures pour des usages à très forte volumétrie.

Le fait que Google et Amazon proposent désormais leurs accélérateurs IA à leurs clients cloud, à des tarifs inférieurs aux GPU génériques, transforme le silicium en arme de compétition commerciale. Google propose à des tiers ses puces TPU et Amazon son Trainium. De fait, Google et Amazon ont signé des contrats pluriannuels de plusieurs milliards de dollars avec d’autres grandes entreprises technologiques et les proposent désormais à leurs clients cloud. (Google a passé un contrat avec Anthropic dans laquelle elle a investi plus de 3 milliards de $). Selon leurs propres estimations, ces puces offrent un rapport coût-performance nettement supérieur à celui des GPU génériques, avec des gains pouvant atteindre 30 à 40 % selon les usages.

De leur côté, Microsoft et Meta n'ont pas encore annoncé la commercialisation de leurs puces Maia et MTIA respectivement. Et OpenAI s’associe à des concepteurs de puces sur mesure, tels que Broadcom, pour concevoir ses propres semi-conducteurs.

Seuls les acteurs disposant d’un trafic interne gigantesque peuvent amortir ces investissements. Oracle, SAP ou Salesforce n’ont ni le volume ni les besoins suffisants ; ils resteront dépendants encore un temps des fournisseurs ou des hyperscalers. À l’inverse, Apple (du fait de l'intégration de l’IA dans ses appareils), Tesla, ByteDance, Alibaba, Tencent, Baidu et Huawei avancent rapidement, ce dernier étant également poussé par les restrictions d’exportation américaines de puces IA vers la Chine.

Les hyperscalers disposent de trois avantages structurels : une demande interne massive et captive des clients, une connaissance intime de leurs usages réels et la capacité de subventionner des investissements matériels lourds par d’autres activités. Le silicium n’est pas leur produit final, mais un outil d’optimisation systémique.

À l’inverse, Nvidia par exemple a bâti sa domination sur une intégration verticale d’un autre type : logicielle. Son CUDA maximise la valeur de ses GPU sans entrer en concurrence frontale avec ses clients hyperscalers. Monter dans le cloud impliquerait des investissements colossaux, des marges plus faibles et un conflit direct avec l’ensemble de son écosystème.

CUDA n’est pas l’équivalent d’un cloud Nvidia ; c’est un mécanisme de verrouillage technologique de ses clients qui est aussi une brillante intégration infrastructurelle hard/soft.

La commercialisation des TPU peut donner l’illusion d’une volonté de devenir un nouvel acteur dominant du semi-conducteur. La réalité semble différente. Pour Google, la puce n’est ni un centre de profit autonome ni le socle d’un écosystème développeur fermé comparable à CUDA.

Le TPU n’est pas le “CUDA de Google”. C’est l’équivalent, pour l’IA, de ce qu’Android fut pour le mobile : un outil stratégique au service d’un écosystème plus large, pas une fin en soi.

La TPU est avant tout un instrument économique au service du cloud. En réduisant fortement le coût de l’inférence et de certaines opérations liées à l’entraînement des LLM, elle renforce l’attractivité de Google Cloud face à AWS et Azure. Le gain principal ne réside pas dans la vente directe de la puce, mais dans l’augmentation des usages, la rétention des clients et la compétitivité globale de l’infrastructure.

La commercialisation répond également à une logique d’amortissement industriel. Chaque génération de TPU mobilise plusieurs centaines de millions, voire plus d’un milliard de dollars . En ouvrant ces accélérateurs à des clients tiers, Google mutualise les volumes, réduit le coût par puce et sécurise le financement des générations futures. La TPU constitue ainsi un avantage comparatif local, intégré dans une stratégie plus large fondée sur les données, les modèles, les services et l’infrastructure.

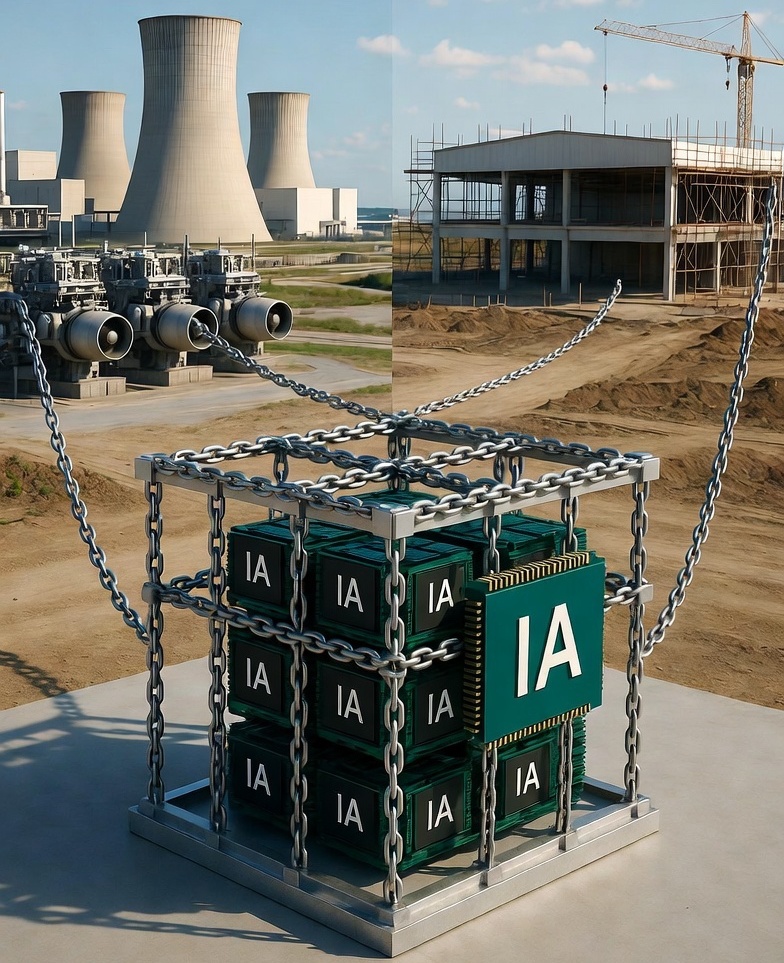

La décision de Microsoft d’investir directement dans des capacités de production énergétique, y compris nucléaires, illustre ce changement de paradigme. L’énergie devient un intrant critique de l’IA, au même titre que le silicium. De même, la pénurie actuelle de mémoires avancées (HBM, DRAM) révèle un nouveau goulot d’étranglement industriel. S’il est peu probable que les hyperscalers fabriquent eux-mêmes de la mémoire à court terme, des partenariats exclusifs, des préfinancements ou des prises de participation apparaissent comme des évolutions plausibles.

Ces investissements ne peuvent être amortis que par des acteurs disposant de volumes colossaux. Oracle, SAP ou Salesforce, faute de trafic suffisant, resteront dépendants des hyperscalers. Comme vu plus haut, à l’inverse, Apple, Tesla, ByteDance, Alibaba, Tencent, Baidu ou Huawei, ce dernier sous contrainte géopolitique, poursuivent des stratégies similaires d’intégration.

La généralisation de l’intégration verticale pose une question stratégique majeure pour les régions situées hors des États-Unis. Si ce modèle devient la norme industrielle de l’IA, ses conséquences ne seront pas uniformes.

Sous l’effet des restrictions américaines à l’exportation de puces d'IA, l’intégration verticale devient moins un choix qu’une nécessité. Malgré des contraintes persistantes sur les outils de gravure les plus avancés, la Chine reproduit la logique américaine : développement de puces spécialisées, contrôle du cloud, optimisation logicielle et intégration étroite des usages.

La situation européenne est d’une nature radicalement différente et plus préoccupante. L’Europe ne dispose ni d’hyperscalers comparables à AWS, Azure ou Google Cloud, ni de plateformes numériques générant des volumes suffisants pour amortir des investissements massifs dans le silicium et l’infrastructure IA. Elle ne possède pas non plus de fabricants de puces IA capables de rivaliser avec Nvidia ou avec les accélérateurs conçus en interne par les géants américains du cloud. Contrairement aux États-Unis ou à la Chine, l’Europe ne peut raisonnablement viser une intégration verticale complète. Chercher à imiter ce modèle conduirait probablement à des projets fragmentés, coûteux et difficilement soutenables. Mais le problème est plus profond : elle ne peut même pas choisir de ne pas jouer. Une fois que les Big Tech auront verrouillé l'ensemble de la chaîne (puces, cloud, modèles, données, énergie) l'Europe se retrouvera dans la position d'un locataire perpétuel, payant une rente technologique croissante sans jamais pouvoir renégocier les termes du bail.

L’idée d’une IA largement ouverte et décentralisée s’éloigne progressivement.

La compétitivité future ne reposera plus seulement sur la qualité des algorithmes ou des données, mais sur la maîtrise conjointe du silicium, des infrastructures et des volumes nécessaires pour les rentabiliser. Une nouvelle compétition industrielle est engagée, et elle se joue autant sur la diversité des architectures matérielles que sur les performances des modèles.

L’Europe, si elle veut rester pertinente, devra impérativement se positionner sur cette chaîne de valeur désormais profondément rematérialisée.

Ce tournant industriel, patiemment préparé depuis une décennie, marque la fin de l’illusion d’un numérique immatériel et facilement décentralisé. Pour les acteurs et les régions qui ne contrôleront pas ces nouvelles infrastructures, le risque n’est plus seulement le retard, mais la dépendance durable.

Si l’intégration verticale dans l'IA s'impose, le risque n’est plus seulement le retard, mais une dépendance structurelle.

Au-delà de la régulation, l’Europe dispose d’atouts sectoriels majeurs (industrie, énergie, santé, mobilité) pour construire une souveraineté fonctionnelle de l’IA, ancrée dans ses usages, ses règles et ses cultures. D'ailleurs, certaines réussites numériques européennes sont nées de la régulation, en faisant émerger des plateformes de confiance et de coordination difficiles à répliquer ailleurs (Doctolib, Blablacar, Trainline, Adyen, Worldline, Trustpilot). À l’inverse, le financement de projets fragmentés et sous-dimensionnés, entravées par des logiques institutionnelles et la lenteur de la coordination interétatique, engendre des initiatives incapables d’atteindre à temps l’échelle critique et décrochent face à l’accélération américaine.

Sans capacités industrielles propres sur les maillons clés de l’IA (puces et infrastructures), la souveraineté numérique européenne restera largement déclarative.

Georges Nahon

Janvier 2026

Du cloud au silicium : Une intégration verticale préparée de longue date

Contrairement à une idée répandue, l’essor récent de l’IA générative n’est pas à l’origine de ce mouvement mais l'a accéléré. Google déploie ses premières TPU (Tensor Processing Unit puce d'accélération d'IA) en interne dès 2015. Amazon rachète Annapurna Labs la même année, Microsoft investit très tôt dans les FPGA (circuits logiques programmables) avec le projet Catapult, tandis que Meta optimise depuis longtemps ses infrastructures matérielles pour ses propres besoins.Pendant près de dix ans, ces développements restent largement invisibles, cantonnés à l’optimisation interne des coûts et des performances. L’IA générative agit comme un révélateur : elle transforme ces investissements de long terme en levier central de compétitivité. À partir de 2024–2025, certaines de ces puces cessent d’être de simples outils internes pour devenir visibles, revendiquées et, dans certains cas, commercialisées auprès de tiers.

L’inférence, nouveau centre de gravité économique de l’IA

Le moteur de cette bascule est avant tout économique. Pour les grands modèles de langage en production, le coût dominant n’est plus l’entraînement, mais l’inférence : les milliards de requêtes quotidiennes issues des moteurs de recherche, assistants et chatbots. Cette phase représente désormais 80 à 90 % de la dépense totale selon certains et 60 à 80% selon d'autres sourcesDans ce contexte, réduire le coût marginal par requête devient un avantage compétitif décisif. En concevant leurs propres accélérateurs, les hyperscalers peuvent optimiser très finement leurs architectures pour des usages à très forte volumétrie.

Signal de marché

L'évolution du discours de Nvidia est révélatrice. Au T2 2024, l'entreprise a mentionné "inference" 12 fois dans ses annonces de résultats financiers. Au T3 2025, elle l'a mentionné 47 fois, près de 4 fois plus. Quand les acteurs dominants adoptent le langage des challengers, cela signale que le paysage concurrentiel a substantiellement changé.Le fait que Google et Amazon proposent désormais leurs accélérateurs IA à leurs clients cloud, à des tarifs inférieurs aux GPU génériques, transforme le silicium en arme de compétition commerciale. Google propose à des tiers ses puces TPU et Amazon son Trainium. De fait, Google et Amazon ont signé des contrats pluriannuels de plusieurs milliards de dollars avec d’autres grandes entreprises technologiques et les proposent désormais à leurs clients cloud. (Google a passé un contrat avec Anthropic dans laquelle elle a investi plus de 3 milliards de $). Selon leurs propres estimations, ces puces offrent un rapport coût-performance nettement supérieur à celui des GPU génériques, avec des gains pouvant atteindre 30 à 40 % selon les usages.

De leur côté, Microsoft et Meta n'ont pas encore annoncé la commercialisation de leurs puces Maia et MTIA respectivement. Et OpenAI s’associe à des concepteurs de puces sur mesure, tels que Broadcom, pour concevoir ses propres semi-conducteurs.

Nvidia prompte à réagir

Avec ses nouvelles puces Vera Rubin présentées en janvier 2026 à Las Vegas, capables de diviser par dix le coût de l’inférence, Nvidia a vite réagi à la montée en puissance des puces IA des hyperscalers, plus économiques et optimisées pour l’inférence. Elle a aussi conclu en décembre 2025 un accord majeur (environ 20 milliards $) avec Groq, fondée par les anciens créateurs du TPU chez Google, produit des puces conçues spécifiquement pour l’inférence, appelées LPUs (Language Processing Units).Investissements colossaux et acquisitions stratégiques

L’investissement est colossal : de 500 millions à plus d’un milliard de dollars par génération de puces IA, plusieurs centaines d’ingénieurs ultraspécialisés et des années de développement. Les rachats de startups pointues comme Annapurna Labs, Agnilis, Habana Labs ou encore Rivos montrent l’importance de sécuriser l’expertise et la propriété intellectuelle.Seuls les acteurs disposant d’un trafic interne gigantesque peuvent amortir ces investissements. Oracle, SAP ou Salesforce n’ont ni le volume ni les besoins suffisants ; ils resteront dépendants encore un temps des fournisseurs ou des hyperscalers. À l’inverse, Apple (du fait de l'intégration de l’IA dans ses appareils), Tesla, ByteDance, Alibaba, Tencent, Baidu et Huawei avancent rapidement, ce dernier étant également poussé par les restrictions d’exportation américaines de puces IA vers la Chine.

Une poignée d’acteurs contrôle l’ensemble de la chaîne

À horizon trois à dix ans, les prix de l’inférence vont fortement baisser, rendant certaines startups non rentables ou les poussant à se faire acquérir ou mourir. Un petit cercle d’acteurs, États-Unis et Chine confondus, contrôlera l’ensemble de la chaîne : données, LLMs, matériel et infrastructure. Reste à voir si l'Europe pourra se positionner dans ce nouveau modèle d'intégration verticale.Une asymétrie structurelle entre hyperscalers et fabricants de puces

Cette dynamique de l'intégration verticale met en lumière une dissymétrie frappante. Les géants du cloud "descendent "la chaîne de valeur vers le silicium, tandis que les acteurs des semi-conducteurs, Nvidia, AMD, Intel, Broadcom ou Qualcomm, ne "remontent" pas vers le cloud, un domaine peu stratégique pour eux et où leur présence reste marginale. Cette asymétrie n’est ni accidentelle ni transitoire mais structurelle.Les hyperscalers disposent de trois avantages structurels : une demande interne massive et captive des clients, une connaissance intime de leurs usages réels et la capacité de subventionner des investissements matériels lourds par d’autres activités. Le silicium n’est pas leur produit final, mais un outil d’optimisation systémique.

À l’inverse, Nvidia par exemple a bâti sa domination sur une intégration verticale d’un autre type : logicielle. Son CUDA maximise la valeur de ses GPU sans entrer en concurrence frontale avec ses clients hyperscalers. Monter dans le cloud impliquerait des investissements colossaux, des marges plus faibles et un conflit direct avec l’ensemble de son écosystème.

CUDA n’est pas l’équivalent d’un cloud Nvidia ; c’est un mécanisme de verrouillage technologique de ses clients qui est aussi une brillante intégration infrastructurelle hard/soft.

Que gagne réellement Google à commercialiser ses TPU ?

La commercialisation des TPU peut donner l’illusion d’une volonté de devenir un nouvel acteur dominant du semi-conducteur. La réalité semble différente. Pour Google, la puce n’est ni un centre de profit autonome ni le socle d’un écosystème développeur fermé comparable à CUDA.Le TPU n’est pas le “CUDA de Google”. C’est l’équivalent, pour l’IA, de ce qu’Android fut pour le mobile : un outil stratégique au service d’un écosystème plus large, pas une fin en soi.

La TPU est avant tout un instrument économique au service du cloud. En réduisant fortement le coût de l’inférence et de certaines opérations liées à l’entraînement des LLM, elle renforce l’attractivité de Google Cloud face à AWS et Azure. Le gain principal ne réside pas dans la vente directe de la puce, mais dans l’augmentation des usages, la rétention des clients et la compétitivité globale de l’infrastructure.

La commercialisation répond également à une logique d’amortissement industriel. Chaque génération de TPU mobilise plusieurs centaines de millions, voire plus d’un milliard de dollars . En ouvrant ces accélérateurs à des clients tiers, Google mutualise les volumes, réduit le coût par puce et sécurise le financement des générations futures. La TPU constitue ainsi un avantage comparatif local, intégré dans une stratégie plus large fondée sur les données, les modèles, les services et l’infrastructure.

L’enjeu sous-jacent est celui d’un arbitrage entre commoditisation et capture des usages.

En l'absence de maîtrise des usages, les fabricants de puces subissent les choix d’optimisation des hyperscalers et risquent la commoditisation progressive. La course actuelle vers l'IAG (IA générale) et les "world models" pourrait rebattre les cartes.L’intégration verticale comme effet de cliquet industriel

Cette intégration verticale crée un effet de cliquet temporel. Plus elle progresse, plus il devient coûteux et long d’entrer sur le marché a posteriori. Le temps industriel de l’IA (conception des puces, construction des data centers, sécurisation énergétique) n’est pas celui des politiques publiques ni des stratégies de rattrapage rapide. D'où un risque d’écart durable entre régions capables d’investir continuellement et celles contraintes de réagir. L’intégration verticale agit ainsi comme un mécanisme cumulatif de concentration du pouvoir industriel.La re-matérialisation du numérique

Historiquement, les phases d’intégration verticale apparaissent lors des grandes ruptures technologiques. IBM dans les années 1960–70, puis Apple avec l’iPhone et Apple Silicon, ont démontré qu’en période d’incertitude technologique, la maîtrise de l’ensemble de la chaîne permettait de capter la valeur et d’imposer des standards. L’IA marque un retour brutal aux contraintes physiques du numérique: calcul, mémoire, réseau, refroidissement et énergie.La décision de Microsoft d’investir directement dans des capacités de production énergétique, y compris nucléaires, illustre ce changement de paradigme. L’énergie devient un intrant critique de l’IA, au même titre que le silicium. De même, la pénurie actuelle de mémoires avancées (HBM, DRAM) révèle un nouveau goulot d’étranglement industriel. S’il est peu probable que les hyperscalers fabriquent eux-mêmes de la mémoire à court terme, des partenariats exclusifs, des préfinancements ou des prises de participation apparaissent comme des évolutions plausibles.

Intégration verticale et trajectoires géopolitiques divergentes

Plusieurs signaux suggèrent que cette dynamique ne s’arrêtera pas aux puces. Les domaines susceptibles d’être intégrés ou fortement contrôlés sont ceux qui conditionnent directement le coût et la fiabilité de l’inférence à grande échelle : interconnexions réseau, photoniques, systèmes de refroidissement, data centers modulaires, outils logiciels optimisés pour des architectures propriétaires, voire production énergétique dédiée.Ces investissements ne peuvent être amortis que par des acteurs disposant de volumes colossaux. Oracle, SAP ou Salesforce, faute de trafic suffisant, resteront dépendants des hyperscalers. Comme vu plus haut, à l’inverse, Apple, Tesla, ByteDance, Alibaba, Tencent, Baidu ou Huawei, ce dernier sous contrainte géopolitique, poursuivent des stratégies similaires d’intégration.

La généralisation de l’intégration verticale pose une question stratégique majeure pour les régions situées hors des États-Unis. Si ce modèle devient la norme industrielle de l’IA, ses conséquences ne seront pas uniformes.

La Chine : intégration verticale et souveraineté technologique

La trajectoire chinoise est relativement lisible. La Chine dispose de grandes entreprises numériques comparables aux Big Tech américaines (Alibaba, Tencent, Baidu, Huawei, ByteDance) capables de combiner plateformes, cloud, logiciels et matériel spécialisé. À cette capacité industrielle s’ajoute un objectif politique explicite : réduire la dépendance aux technologies numériques étrangères, en particulier américaines.Sous l’effet des restrictions américaines à l’exportation de puces d'IA, l’intégration verticale devient moins un choix qu’une nécessité. Malgré des contraintes persistantes sur les outils de gravure les plus avancés, la Chine reproduit la logique américaine : développement de puces spécialisées, contrôle du cloud, optimisation logicielle et intégration étroite des usages.

L’Europe : le risque d’un décrochage structurel

Si le modèle d’intégration verticale à l’américaine se généralise, le risque dépasse le simple retard technologique. Il s’agit d’un risque de dépendance systémique. Une fois que les Big Tech auront intégré étroitement puces, clouds, modèles, données et énergie, elles disposeront d’attributs difficiles à concurencer : coûts d’inférence structurellement plus bas, vitesse d’itération supérieure, subvention croisée entre services et verrouillage économique et technique renforcée.L'Europe face au mur de l'intégration verticale

Si le modèle d'intégration verticale à l'américaine se généralise, l'Europe ne fait pas face à un simple retard technologique, mais à un piège structurel dont il n'existe peut-être aucune sortie honorable.La situation européenne est d’une nature radicalement différente et plus préoccupante. L’Europe ne dispose ni d’hyperscalers comparables à AWS, Azure ou Google Cloud, ni de plateformes numériques générant des volumes suffisants pour amortir des investissements massifs dans le silicium et l’infrastructure IA. Elle ne possède pas non plus de fabricants de puces IA capables de rivaliser avec Nvidia ou avec les accélérateurs conçus en interne par les géants américains du cloud. Contrairement aux États-Unis ou à la Chine, l’Europe ne peut raisonnablement viser une intégration verticale complète. Chercher à imiter ce modèle conduirait probablement à des projets fragmentés, coûteux et difficilement soutenables. Mais le problème est plus profond : elle ne peut même pas choisir de ne pas jouer. Une fois que les Big Tech auront verrouillé l'ensemble de la chaîne (puces, cloud, modèles, données, énergie) l'Europe se retrouvera dans la position d'un locataire perpétuel, payant une rente technologique croissante sans jamais pouvoir renégocier les termes du bail.

Pour l'Europe : une intégration sélective

Une réponse crédible passe par une intégration stratégique sélective, coordonnée à l’échelle continentale : infrastructures de calcul mutualisées, interconnexions réseau, logiciels système, orchestration des modèles, efficacité énergétique et sécurité des données.L’IA comme infrastructure stratégique

À mesure que l’IA devient une industrie lourde, l’intégration verticale confère aux acteurs qui la maîtrisent un pouvoir économique, technologique et politique inédit. La compétition ne se joue plus uniquement sur les algorithmes ou les données, mais sur la maîtrise conjointe du matériel, de l’infrastructure et des ressources physiques qui rendent l’IA exploitable à grande échelle.L’idée d’une IA largement ouverte et décentralisée s’éloigne progressivement.

La compétitivité future ne reposera plus seulement sur la qualité des algorithmes ou des données, mais sur la maîtrise conjointe du silicium, des infrastructures et des volumes nécessaires pour les rentabiliser. Une nouvelle compétition industrielle est engagée, et elle se joue autant sur la diversité des architectures matérielles que sur les performances des modèles.

L’Europe, si elle veut rester pertinente, devra impérativement se positionner sur cette chaîne de valeur désormais profondément rematérialisée.

Ce tournant industriel, patiemment préparé depuis une décennie, marque la fin de l’illusion d’un numérique immatériel et facilement décentralisé. Pour les acteurs et les régions qui ne contrôleront pas ces nouvelles infrastructures, le risque n’est plus seulement le retard, mais la dépendance durable.

L’Europe face au risque d’une souveraineté (seulement) déclarative

La situation de l’Europe sans hyperscalers comparables ni de fabricants de puces d’IA capables de rivaliser est préoccupante. L'implantation d'Intel en Allemagne a été arrêtée, et la création d'une fabrication de puces en France par STMicroelectronics et GlobalFounderies est au ralenti.Si l’intégration verticale dans l'IA s'impose, le risque n’est plus seulement le retard, mais une dépendance structurelle.

Une réponse crédible ne peut plus passer par l’imitation ou le suivisme

Ainsi, à mesure que l’IA devient une infrastructure stratégique, la compétition se joue sur la maîtrise conjointe du matériel, des infrastructures et des ressources physiques.Au-delà de la régulation, l’Europe dispose d’atouts sectoriels majeurs (industrie, énergie, santé, mobilité) pour construire une souveraineté fonctionnelle de l’IA, ancrée dans ses usages, ses règles et ses cultures. D'ailleurs, certaines réussites numériques européennes sont nées de la régulation, en faisant émerger des plateformes de confiance et de coordination difficiles à répliquer ailleurs (Doctolib, Blablacar, Trainline, Adyen, Worldline, Trustpilot). À l’inverse, le financement de projets fragmentés et sous-dimensionnés, entravées par des logiques institutionnelles et la lenteur de la coordination interétatique, engendre des initiatives incapables d’atteindre à temps l’échelle critique et décrochent face à l’accélération américaine.

Sans capacités industrielles propres sur les maillons clés de l’IA (puces et infrastructures), la souveraineté numérique européenne restera largement déclarative.

Georges Nahon

Janvier 2026

Autres articles sur le même thème

Quoi de neuf dans la Silicon Valley ?

IA aux USA : Bulle ou boum ? Surtout du béton et des usines à Gaz

par Georges Nahon

par Georges Nahon

Mag #29

Lire l'article

Quoi de neuf dans la Silicon Valley ?

Quand les entreprises parlent d’IA mais ne l’utilisent pas vraiment (encore)

Mag #28

Lire l'article