L'arbre de l'IA peut-il monter jusqu'au ciel ?par Georges Nahon

Comment l’open Source change la donne dans l’intelligence artificielle et la course au gigantisme

Les systèmes d'IA génératif comme ChatGPT et ses cousins sont basés sur des algorithmes qui s'entrainent en analysant des quantités énormes de données. Ils sont basés sur des grands modèles linguistiques (LLMs). Un LLM est un type d’algorithme d’intelligence artificielle (IA) qui utilise des techniques d’apprentissage en profondeur (deep learning) et des énormes ensembles de données pour comprendre, résumer, traduire, prédire et générer de nouveaux contenus textuels et autres comme images, sons et vidéo. Les grands modèles linguistiques sont parmi les applications les plus réussies des modèles dits de "transformateurs" dont Google a inventé le principe et conçu le premier exemplaire.Le premier de ces modèles linguistiques, GPT-2, a été annoncé par la société OpenAI en 2019. Il avait 1,5 milliard de paramètres, ce qui paraissait énorme. En 2020, GPT-3 est sorti avec 175 milliards de paramètres. Et avec GPT-4 on en est à 170 000 milliards ! Le nombre de paramètres est une mesure de la taille et de la complexité du modèle. Plus un modèle comporte de paramètres, plus il peut traiter, apprendre et générer de données.

L'IA n'étant pas parfait dans ses résultats, une façon d'en améliorer la véracité et la précision est d'augmenter ses "connaissances" pour que ses réseaux neuronaux "réfléchissent" mieux et plus vite.

La course (ultra rapide) à la croissance des IA génératifs depuis la fin 2022, et surtout de celle de leurs sources d'apprentissage, semblait inéluctable vu l'extrême concurrence entre les Big Tech ou les Big IAs comme OpenAI.

Mais on commence à entendre des opinions plus réservées et on voit apparaitre d'autres solutions concurrentes aux approches gigantesques. Sam Altman, le PDG d'OpenAI lui-même partageait récemment son sentiment sur cette question :

La taille des LLMs n’aura pas autant d’importance à l’avenir "Je pense que nous sommes à la fin de l’ère où on aura ces modèles géants, et nous les améliorerons d’autres façons"

Par ailleurs, de plus en plus de faits suggèrent que la capacité généraliste des LLMs est considérablement limitée par la qualité des données d'entrainement.

Il semble y avoir plusieurs raisons à ce changement de posture vis-à-vis des avantages liés à la taille.

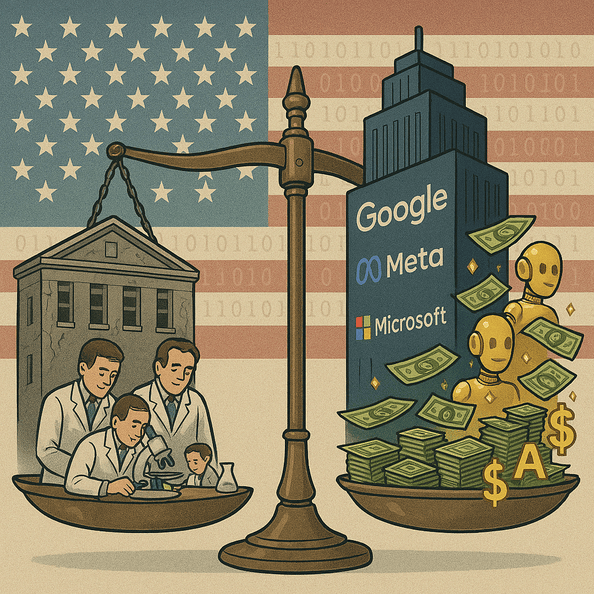

D'abord le coût de l'entrainement des IA et de ses modelés linguistiques (y compris le cout énergétique) est considérable. Cela rendrait l'accès à ces technologies très cher et le ticket d'entrée pourrait barrer l'accès aux startups et autres innovateurs. Et cela, soit dit en passant, préoccupe beaucoup l'administration Biden aux USA.Voici ce que disait la Vice-Présidente Kamala Harris la veille de recevoir début mai 2023 des patrons des Big Tech et d'OpenAi à la Maison blanche pour discuter des meilleures décisions à prendre pour encadrer le développement de l'IA sans toucher à la compétitivité américaine dans ce domaine notamment vis à vis de la Chine :

"L’adoption croissante de l’IA risque de verrouiller davantage la domination du marché par des grandes entreprises technologiques en place. Une poignée d’entreprises puissantes contrôlent les matières premières nécessaires sur lesquelles les start-ups et autres entreprises comptent pour développer et déployer des outils d’IA Cela inclut les services cloud et la puissance de calcul, ainsi que de vastes réserves de données Les entreprises dominantes pourraient utiliser leur contrôle sur ces intrants clés pour exclure ou discriminer leurs rivaux en aval, choisir les gagnants et les perdants de manière à renforcer leur domination."

Selon the economist, l'entrainement de GPT-3, par exemple, a utilisé 1,3 gigawatt heure d’électricité (assez pour alimenter 121 foyers en Amérique pendant un an) et a coûté à OpenAI environ 4,6 millions de dollars. GPT-4, qui est un modèle beaucoup plus grand, aura coûté beaucoup plus cher (de l'ordre de 100 millions de dollars) à entrainer. Dans la mesure où les exigences de puissance de calcul, augmentent considérablement plus rapidement que les données d’entrée, l'entrainement des LLMs devient coûteuse plus rapidement qu’elle ne s’améliore.

Ensuite, le cout d'exploitation est lui aussi élevé : pour ChatGPT il serait de l'ordre de 700 000 $ par jour. Car il faut utiliser des serveurs spécifiques très onéreux. Ce qui pousse par exemple Microsoft à développer ses propres circuits intégrés spécifiques (CPU/GPU) pour l'IA. Un accord a d'ailleurs été conclu début mai 2023 avec le fabricant de puces AMD pour notamment concurrence Nvidia qui domine ce secteur.

ChatGPT a déjà coûté une fortune avec les pertes d’OpenAI atteignant 540 millions de dollars l’année dernière. Même si le chiffre d’affaires croit régulièrement. Et depuis sa création fin 2015, OpenAI a jusqu’à présent levé un total de $11.3B en sept tours.

Le PDG Sam Altman aurait indiqué qu’OpenAI pourrait essayer de lever jusqu’à 100 milliards de dollars dans les années à venir pour atteindre son objectif de développer une intelligence artificielle générale très avancée. OpenAI, selon un observateur, « deviendrait la startup la plus consommatrice de capitaux de l’histoire de la Silicon Valley »

Parmi les coûts en forte croissance, notamment les coûts de formation de ses logiciels, OpenAI va devoir payer les fournisseurs de contenus pour accéder à des ensembles de leurs données qui ne sont pas sur Internet et qu’il voudrait utiliser pour développer son IA. Mais aussi des données disponibles en accès libre sur le Web qui vont devenir payants pour tous les entraineurs d’IA comme OpenAI.

Et enfin, une raison du changement des positions acquises dans la course au gigantisme des LLMs, serait la montée en puissance dans l'IA de la communauté mondiale de l'open source qui a vite compris l'avantage qu'elle pourrait tirer de l'accès à des outils d'IA très puissants dont LLaMa de Meta/facebook qui aurait fui par erreur dans la nature le 3 mai 2023. Mais pas perdu pour tout le monde ; il n’y avait pas de guide d’utilisation mais cela n’a pas empêché la communauté de comprendre immédiatement l’importance de ce qui leur avait été donné. Une énorme vague d’innovation a suivi, avec seulement quelques jours entre les annonces de développements majeurs.

L’émergence des agents autonomes d’IA comme BabyAGI et autoGPT

Un autre aspect est l’évolution de ChatGPT, d’une application à une plateforme où les développeurs peuvent se connecter via des APIs (interface de programmation d'application) et créer de nouveaux outils ou services. Un premier exemple en est AutoGPT. Selon la littérature abondante disponible, AutoGPT permet à différents modèles linguistiques comme celui de ChatGPT de communiquer entre eux et on peut avoir des agents qui travaillent en arrière-plan qui peuvent se parler, puis accomplir des tâches sans trop d’intervention humaine.

AutoGPT peut faire beaucoup de choses que ChatGPT ne peut pas faire. En effet, contrairement à ChatGPT où l’on envoie une invite (prompt) après l’autre en fonction des résultats obtenus avec la précédente, avec AutoGPT, une fois notre objectif exprimé, le système travaille tout seul et se créée ses propres étapes et avance de façon quasi autonome.

Il peut aussi se connecter au web et à des sites qu’il "juge" utile de consulter notamment pour disposer des informations les plus récentes on indisponibles dans le fonds documentaire qui a servi à entrainer l’IA concerné.

Cela signifie qu’AutoGPT peut s’auto solliciter. Dans la pratique on indique à AutoGPT quel doit être l’objectif final et l’application auto-produira toutes les invites pour accomplir la tâche. C’est la base d’un comportement autonome de l’IA. C'est ce qui est nouveau et fascinant. En résumé, AutoGPT est un agent autonome d’IA.

On voit donc qu’avec des APIs on peut augmenter des services d’intelligence générative sans augmenter la taille des LLMs concernés. Des développeurs de startups trouveront d'autres moyens de les améliorer. Ce qui mettra rapidement à la portée des entreprises et institutions l'utilisation personnalisée de l'IA générative secteur par secteur.

D’autres agents autonomes sont apparus dont LangChain et Pinecone, on peut tester le concept de l’agent autonome sur AgentGPT qui est un cousin d’AutoGPT.

Un autre agent autonome d’IA fait aussi parler de lui abondamment ; s’agit de BabyAGI (AGI=Artificial general intelligence[1]).

Cet agent autonome n’est pas vraiment capable d’exposer une intelligence artificielle générale. Mais comme AutoGPT et d’autres produits similaires, leur nature open source pourrait constituer une menace pour un certain nombre de startups de haut niveau et bien financées qui tentent de créer des assistants commerciaux d’IA en mode propriétaire comme Inflection AI et Adept AI. Ils pourraient également apporter des solutions concurrentes compétitives pour de nouveaux usages non prévus par chat GPT.

Toutefois l’usage actuel de ces agents autonomes d’IA n’est pas gratuit car l’accès aux API de chatGPT sont payants à chaque usage.

En effet, pour le moment ces agents autonomes open source se connectent à ChatGPT et en sont dépendants mais il est envisageable qu’ils se connectent à l’avenir sur des LLMs issus de l’open source.

La course à la taille des LLMs devrait se calmer selon un document interne de Google

Dans le cadre d’une fuite d’un document interne, les révélations et analyses d’un ingénieur/chercheur anonyme de Google laissent penser que les enjeux sont en train d’évoluer rapidement dans le monde de l’IA génératif. On suppose que ce document très bien articulé et informé est authentique…

"Bien que nos modèles conservent encore un léger avantage en termes de qualité, l’écart se réduit étonnamment rapidement. Les modèles open source sont plus rapides, plus personnalisables, plus privés et plus performants. Ils font des choses avec 100 $ et 13 milliards de paramètres avec lesquels nous avons du mal avec 10 millions de dollars et 540 milliards de paramètres. Et ils le font en quelques semaines, pas en quelques mois.

Les gens ne paieront pas pour un modèle restreint lorsque les alternatives gratuites et sans restriction sont de qualité comparable. ….. Les modèles géants nous ralentissent. À long terme, les meilleurs modèles sont ceux qui peuvent être itérés rapidement. Nous devrions faire de petites variantes plutôt que de réfléchir après coup, maintenant que nous savons ce qui est possible dans la gamme de moins de 20 milliards de paramètres"

Et encore :

"Plus important encore, ils ont résolu le problème du passage à l’échelle dans la mesure où n’importe qui peut bricoler (expérimenter, bidouiller). Beaucoup des nouvelles idées viennent de gens ordinaires. La barrière à l’entrée pour la formation et l’expérimentation est passée de la production totale d’un grand organisme de recherche à une personne, une soirée et un ordinateur portable costaud."

La participation du public à faible coût a été rendue possible par un mécanisme beaucoup moins coûteux de réglage fin appelé adaptation de bas rang, ou LoRA, pour la génération d’images inventé par Microsoft. (Rien à voir avec Lora, le protocole de communication radio pour l'Internet des objets).

En gros, lorsque l’on veut créer un modèle spécifique à un domaine, il n’est pas nécessaire de ré-entraîner tous les paramètres du modèle, mais seulement ceux que l’on veut modifier.

Dans le monde des images, une conséquence est que l’intérêt pour le challenger Stable Diffusion croit plus rapidement que pour le leader Dall-E. Le même impact pourrait se produire dans le monde des LLMs.

Certaines conclusions de l'ingénieur de Google sont particulièrement instructives comme par exemple :

-

Les grands modèles ne seront pas plus compétents à long terme si on peut itérer rapidement sur des petits modèles.

-

La qualité des données passe mieux à l’échelle que la taille des données.

Dans les semaines qui ont suivi la "fuite" de LLaMa, on a vu apparaitre des développements surprenants venant de développeurs indépendants, ou d’universités et d’autres acteurs en dehors des Big IAs.

Par exemple le modèle LLaMa peut maintenant tourner (lentement) sur des petits appareils comme un petit ordinateur Raspberry Pi ou un PC. L’université de Stanford a mis au point Alpaca qui complète LLaMa et une version dite Alpaca-lora qui tourne sur un seul processeur graphique. Il y a aussi un LLM sur un smartphone.

La transformation en marche du terrain de jeu de l’IA

En quelques mois la physionomie du paysage de l’IA et de ses acteurs a changé et ce changement est en marche rapide. Google est challengé par Microsoft dans son activité cœur : le moteur de recherche, pendant que Facebook, Amazon, Box, Salesforce etc. et de nombreux acteurs établis offrent maintenant des solutions à leurs clients existants six mois après la sortie de ChatGPT.

Le besoin des entreprises et des institutions de disposer de leurs propres LLMs va amplifier le mouvement de déconcentration à l’écart des seuls Big IAs au profit de nouvelles sociétés avec des solutions originales.

Historiquement, l’exemple d’Internet montre que la combinaison open source et produits propriétaires est finalement viable et porteuse de forte croissance. Cela a été le cas pour le développement d’Internet notamment avec la montée en puissance de Linux coté serveurs. La participation des grosses et petites entreprises de tech a permis d’arriver à un résultat plus que probant, souvent avec des contributions venant du monde universitaire. Et des géants comme Google, Yahoo, Amazon, Facebook etc.… sont nés pendant que les acteurs historiques transformaient leurs offres de produits pour s’adapter à la nouvelle donne technologique. En dehors de Kodak, et quelques autres, tout l’ancien monde est toujours là mais avec un nouveau visage, à côté des nouveaux venus.

Dans le contexte de l’IA, la rapide participation de l’open source peut accomplir le même résultat.

De nouveaux acteurs importants apparaissent du côté des Big Tech comme OpenAI et une série de sociétés originales comme Midjourney et Huggins Face. Certaines fusionneront entre elles, d’autres seront acquises et il restera à côté des Big Tech historiques quelques nouveaux grands acteurs autour desquelles des startups continueront de se développer notamment avec les transfuges des BigTech. Un cycle bien connu dans la Silicon Valley.

L’open source va changer profondément et durablement l’IA et ses acteurs. Cela parait inévitable.

Georges Nahon

10 mai 2023

Sources : the Atlantic, The economist, CNBC, OpenAI, Insider, Nvidia, Wired, Fortune, SemiAnalysis, the Financial Times, et d’autres.

NB : aucun passage de cet article n’a été ni écrit, ni révisé par ChatGPT ou équivalent.

[1] AGI, ou intelligence artificielle générale, se réfère à une forme d'IA qui est capable de comprendre, d'apprendre et d'accomplir n'importe quelle tâche cognitive qu'un être humain peut accomplir.

Autres articles sur le même thème

par Georges Nahon

par Georges Nahon